Шанхайський стартап у сфері штучного інтелекту MiniMax приголомшив індустрію своєю новою мовною моделлю M2.5, представивши її у двох варіантах. Ці розробки обіцяють зробити передовий штучний інтелект настільки доступним, що ви можете забути про рахунки.

Модель стала відкритим кодом на платформі Hugging Face під модифікованою ліцензією MIT. Вона вимагає, щоб ті, хто використовує модель (або її кастомізовані варіанти) для комерційних цілей, “чітко відображали ‘MiniMax M2.5’ в інтерфейсі користувача такого продукту чи послуги”.

Однак це майже другорядне питання, зважаючи на низьку вартість, за якою MiniMax надає доступ до неї через власний API та API партнерів.

Протягом останніх кількох років користування найпотужнішими ШІ-моделями світу нагадувало наймання дорогого консультанта – це було блискуче, але ви постійно стежили за часом (і кількістю токенів). M2.5 змінює цю динаміку, знижуючи вартість передових рішень до 95%.

Забезпечуючи продуктивність, яка конкурує з топовими моделями від Google та Anthropic за частку їхньої ціни, особливо в галузі використання інструментів для корпоративних завдань, включно зі створенням файлів Microsoft Word, Excel та PowerPoint, MiniMax робить ставку на те, що майбутнє полягає не лише в інтелекті моделі, а й у тому, наскільки часто ви можете собі дозволити її використовувати.

Дійсно, з цією метою MiniMax заявляє, що співпрацював “з провідними фахівцями у таких галузях, як фінанси, право та соціальні науки”, щоб забезпечити відповідність моделі їхнім специфікаціям та стандартам для виконання реальних завдань.

Випуск M2.5 має велике значення, оскільки він сигналізує про зміну парадигми – від ШІ як “чат-бота” до ШІ як “працівника”. Коли інтелект стає “настільки дешевим, що його неможливо виміряти”, розробники перестають створювати прості інструменти для запитань і відповідей і починають будувати “агентів” – програмне забезпечення, здатне годинами автономно кодувати, досліджувати та організовувати складні проєкти, не розоряючи бюджет.

Насправді MiniMax вже інтегрував цю модель у власні операційні процеси. Наразі 30% усіх завдань у головному офісі MiniMax виконується M2.5, а вражаючі 80% нового коду, що розробляється, генерується M2.5!

Як зазначає команда MiniMax у своєму блозі, “ми віримо, що M2.5 надає практично безмежні можливості для розробки та експлуатації агентів в економіці”.

Технологія: розріджена потужність та прорив CISPO

Секрет ефективності M2.5 криється в її архітектурі “Суміш експертів” (Mixture of Experts, MoE). Замість того, щоб задіювати всі свої 230 мільярдів параметрів для кожного згенерованого слова, модель “активує” лише 10 мільярдів. Це дозволяє їй зберігати глибину міркувань великої моделі, одночасно рухаючись з гнучкістю значно меншої.

Для тренування цієї складної системи MiniMax розробив власну систему навчання з підкріпленням (Reinforcement Learning, RL) під назвою Forge. Інженер MiniMax Олів Сонг зазначила в подкасті ThursdAI на YouTube, що ця техніка була ключовою для масштабування продуктивності навіть при використанні відносно невеликої кількості параметрів, і що модель тренувалася протягом двох місяців.

Forge розроблено для того, щоб допомогти моделі вчитися на “реальних середовищах” – фактично, дозволяючи ШІ практикувати кодування та використання інструментів у тисячах симульованих робочих просторів.

“Ми зрозуміли, що в невеликої моделі, як ця, є величезний потенціал, якщо тренувати її з підкріпленням у великій кількості середовищ та агентів,” – сказала Сонг. “Але це непросте завдання,” додавши, що саме над цим вони “довго працювали”.

Для забезпечення стабільності моделі під час інтенсивного тренування використовувався математичний підхід під назвою CISPO (Clipping Importance Sampling Policy Optimization), формулу якого компанія опублікувала у своєму блозі.

Ця формула гарантує, що модель не робить надмірних корекцій під час тренування, дозволяючи їй розвинути те, що MiniMax називає “Мистецтвом архітектора”. Замість того, щоб одразу переходити до написання коду, M2.5 навчилася проактивно планувати структуру, функції та інтерфейс проєкту.

Найсучасніші (і майже) бенчмарки

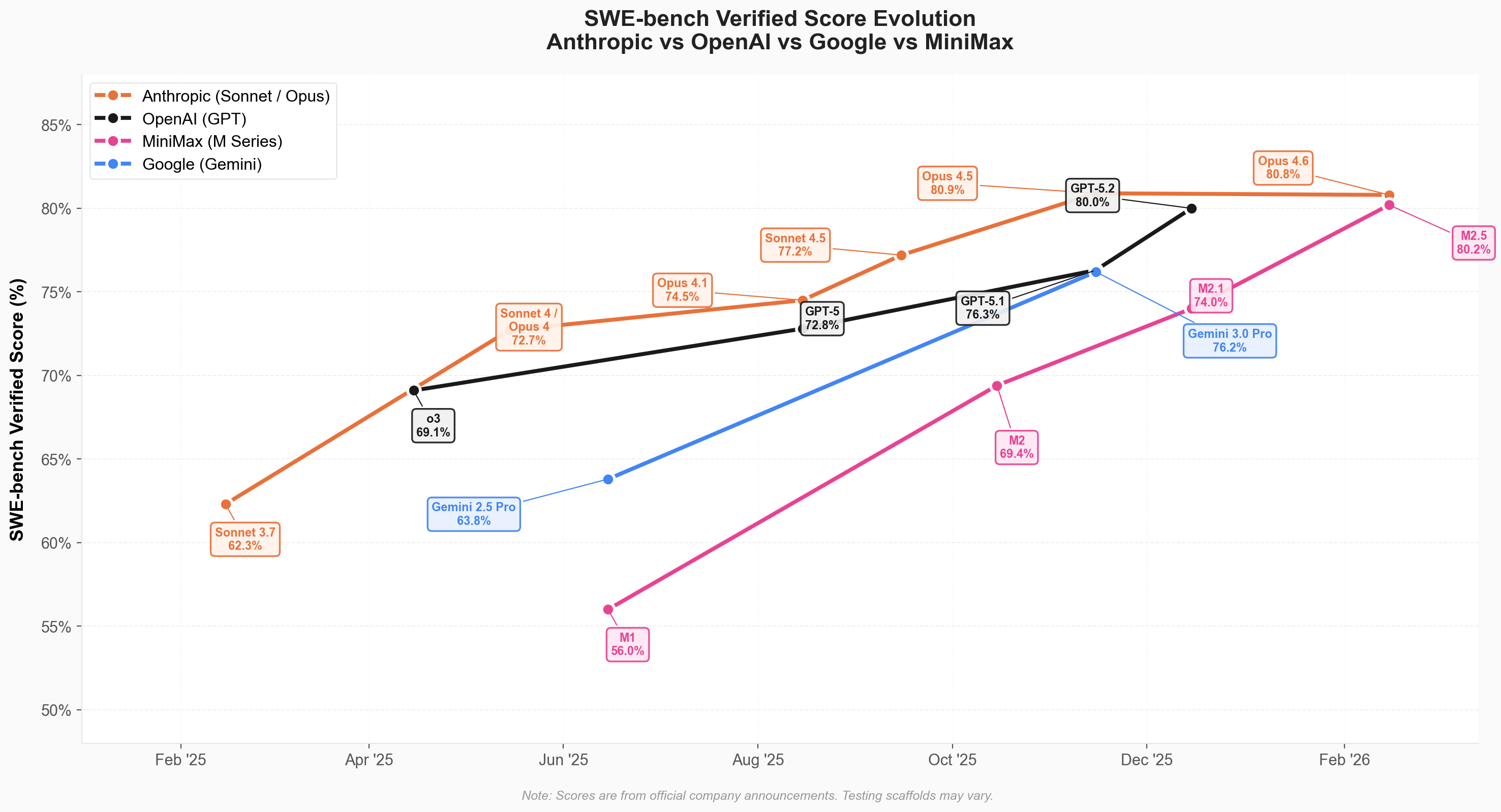

Результати цієї архітектури відображені в останніх рейтингах галузі. M2.5 не просто покращилася; вона увірвалася до еліти кодуючих моделей, наблизившись до найновішої моделі від Anthropic, Claude Opus 4.6, випущеної лише тиждень тому. Це свідчить про те, що китайські компанії тепер наближаються до значно краще забезпечених (з точки зору GPU) американських лабораторій.

Серед нових показників MiniMax M2.5:

-

SWE-Bench Verified: 80.2% — Відповідає швидкості Claude Opus 4.6

-

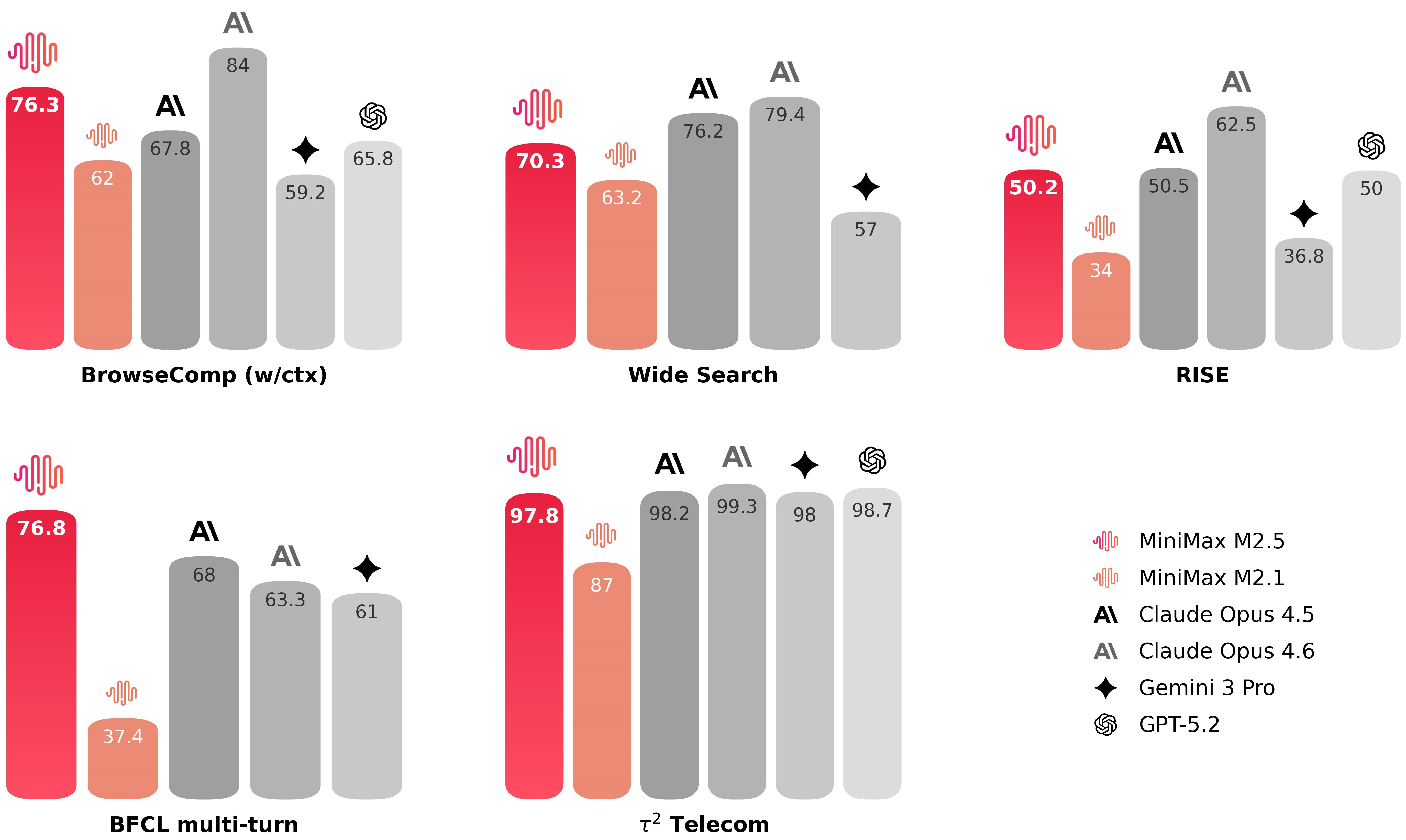

BrowseComp: 76.3% — Провідне у галузі пошуку та використання інструментів.

-

Multi-SWE-Bench: 51.3% — Найкращий результат (SOTA) у багатомовному кодуванні

-

BFCL (Виклик інструментів): 76.8% — Високоточні агентні робочі процеси.

У подкасті ThursdAI ведучий Алекс Волков зазначив, що MiniMax M2.5 працює надзвичайно швидко, тому використовує менше токенів для виконання завдань – близько 0.15 долара за завдання, порівняно з 3.00 доларами за Claude Opus 4.6.

Подолання цінового бар’єру

MiniMax пропонує дві версії моделі через власний API, обидві орієнтовані на високооб’ємне виробниче використання:

-

M2.5-Lightning: Оптимізована для швидкості, забезпечує 100 токенів за секунду. Вартість становить 0.30 долара за 1 мільйон вхідних токенів і 2.40 долара за 1 мільйон вихідних токенів.

-

Standard M2.5: Оптимізована для економії коштів, працює зі швидкістю 50 токенів за секунду. Вартість удвічі нижча за версію Lightning (0.15 долара за 1 мільйон вхідних токенів / 1.20 долара за 1 мільйон вихідних токенів).

Простими словами: MiniMax стверджує, що ви можете запускати чотири “агенти” (ШІ-працівники) безперервно протягом цілого року приблизно за 10 000 доларів.

Для корпоративних користувачів така ціна приблизно в 10-20 разів нижча, ніж у конкурентних пропрієтарних моделей, як-от GPT-5 або Claude 4.6 Opus.

|

Модель |

Вхідні дані |

Вихідні дані |

Загальна вартість |

Джерело |

|

Qwen 3 Turbo |

0.05$ |

0.20$ |

0.25$ |

Alibaba Cloud |

|

deepseek-chat (V3.2-Exp) |

0.28$ |

0.42$ |

0.70$ |

DeepSeek |

|

deepseek-reasoner (V3.2-Exp) |

0.28$ |

0.42$ |

0.70$ |

DeepSeek |

|

Grok 4.1 Fast (міркування) |

0.20$ |

0.50$ |

0.70$ |

xAI |

|

Grok 4.1 Fast (не міркування) |

0.20$ |

0.50$ |

0.70$ |

xAI |

|

MiniMax M2.5 |

0.15$ |

1.20$ |

1.35$ |

MiniMax |

|

MiniMax M2.5-Lightning |

0.30$ |

2.40$ |

2.70$ |

MiniMax |

|

Gemini 3 Flash Preview |

0.50$ |

3.00$ |

3.50$ |

|

|

Kimi-k2.5 |

0.60$ |

3.00$ |

3.60$ |

Moonshot |

|

GLM-5 |

1.00$ |

3.20$ |

4.20$ |

Z.ai |

|

ERNIE 5.0 |

0.85$ |

3.40$ |

4.25$ |

Baidu |

|

Claude Haiku 4.5 |

1.00$ |

5.00$ |

6.00$ |

Anthropic |

|

Qwen3-Max (2026-01-23) |

1.20$ |

6.00$ |

7.20$ |

Alibaba Cloud |

|

Gemini 3 Pro (≤200K) |

2.00$ |

12.00$ |

14.00$ |

|

|

GPT-5.2 |

1.75$ |

14.00$ |

15.75$ |

OpenAI |

|

Claude Sonnet 4.5 |

3.00$ |

15.00$ |

18.00$ |

Anthropic |

|

Gemini 3 Pro (>200K) |

4.00$ |

18.00$ |

22.00$ |

|

|

Claude Opus 4.6 |

5.00$ |

25.00$ |

30.00$ |

Anthropic |

|

GPT-5.2 Pro |

21.00$ |

168.00$ |

189.00$ |

OpenAI |

Стратегічні наслідки для підприємств та лідерів

Для технічних керівників M2.5 — це більше, ніж просто дешевший API. Це кардинально змінює операційну стратегію для підприємств вже сьогодні.

Зник тиск необхідності “оптимізувати” запити заради економії. Тепер можна впроваджувати моделі з високим контекстом і потужними міркуваннями для рутинних завдань, які раніше були недоступні через високу вартість.

37% прискорення виконання завдань означає, що “агентні” конвеєри, ціновані оркестраторами ШІ — де моделі взаємодіють одна з одною, — нарешті працюють достатньо швидко для застосунків реального часу.

Крім того, високі показники M2.5 у фінансовому моделюванні (74.4% на MEWC) свідчать про її здатність обробляти “неявні знання” спеціалізованих галузей, таких як право та фінанси, з мінімальним наглядом.

Оскільки M2.5 позиціонується як модель з відкритим кодом, організації потенційно можуть проводити масштабні автоматизовані аудити коду, що раніше було неможливо без значного залучення людських ресурсів, одночасно краще контролюючи конфіденційність даних.

MiniMax M2.5 є сигналом того, що майбутнє ШІ – це не лише змагання за створення найбільшого “мозку”, а за те, хто зможе зробити цей “мозок” найкориснішим і найдоступнішим “працівником”.

Порада від ІТ-Блог: Нова модель M2.5 від MiniMax — це справжній прорив для компаній, які прагнуть ефективно використовувати потужний ШІ без значних витрат. Якщо ваша діяльність пов’язана зі створенням контенту, аналізом даних, розробкою програмного забезпечення або автоматизацією бізнес-процесів, ця модель може суттєво оптимізувати ваші робочі процеси та знизити операційні витрати.

Оригінал статті: venturebeat.com