Компанія Alibaba представила новітню модель Qwen 3.5 цього тижня, приурочивши реліз до китайського Нового року. Вражаючі показники цієї розробки вже привернули увагу фахівців з корпоративного AI.

Нова флагманська модель з відкритим кодом – Qwen3.5-397B-A17B – має 397 мільярдів параметрів, але для обробки кожного токена задіює лише 17 мільярдів. Заявляється, що вона перевершує попередній флагман Alibaba, Qwen3-Max, модель, яка, за визнанням компанії, мала понад трильйон параметрів.

Цей випуск є знаковим моментом у сфері корпоративних закупівель рішень на базі штучного інтелекту. Для IT-лідерів, що оцінюють інфраструктуру ШІ на 2026 рік, Qwen 3.5 пропонує новий підхід: модель, яку можна реально запускати, володіти та контролювати, тепер може змагатися з тими, які доводиться орендувати.

Нова архітектура для швидкості в масштабі

Інженерні рішення, що лежать в основі Qwen 3.5, походять від її попередніх версій. Модель є прямим наступником експериментальної Qwen 3-Next, представленої у вересні минулого року. Це була надзвичайно розріджена модель типу MoE (Mixture of Experts), яка вважалася наполовину завершеною. Qwen 3.5 розвиває цю архітектурну концепцію, масштабуючи її: кількість експертів зросла зі 128 у попередніх моделях Qwen 3 MoE до 512 у новій версії.

Практичні переваги цього, а також вдосконалений механізм уваги, полягають у значному зниженні затримок під час виведення результатів (inference). Оскільки для кожного проходу обробки задіяно лише 17 мільярдів з 397 мільярдів параметрів, обчислювальні ресурси, що використовуються, значно ближчі до щільної моделі на 17 мільярдів параметрів, ніж до моделі на 400 мільярдів. При цьому модель може використовувати всю глибину свого пулу експертів для спеціалізованих міркувань.

Цей приріст швидкості є суттєвим. При довжині контексту 256K, Qwen 3.5 декодує в 19 разів швидше, ніж Qwen3-Max, і в 7.2 рази швидше, ніж модель Qwen 3 235B-A22B.

Alibaba також стверджує, що експлуатація моделі на 60% дешевша порівняно з її попередницею та в 8 разів ефективніша у справі обробки великої кількості одночасних запитів. Ці показники надзвичайно важливі для будь-якої команди, яка уважно стежить за витратами на інференс. Вартість також приблизно в 18 разів менша, ніж у Gemini 3 Pro від Google.

Ще два архітектурні рішення посилюють ці переваги:

-

Qwen3.5 підтримує передрук з використанням кількох токенів – підхід, вперше використаний у кількох пропрієтарних моделях. Це прискорює збіжність попереднього навчання та збільшує пропускну здатність.

-

Вона також успадковує систему уваги від Qwen3-Next, випущеної минулого року. Ця система спеціально розроблена для зменшення навантаження на пам’ять при роботі з дуже довгими контекстними вікнами.

Результатом є модель, яка може комфортно працювати в межах контекстного вікна 256K у версії з відкритим кодом, і до 1 мільйона токенів у хостинговій версії Qwen3.5-Plus, доступній через Alibaba Cloud Model Studio.

Нативна мультимодальність, а не доповнення

Роками Alibaba дотримувалася стандартного галузевого підходу: створити мовну модель, а потім приєднати до неї візуальний енкодер для створення окремого варіанту VL (Vision-Language). Qwen 3.5 повністю відкидає цю практику. Модель тренується з нуля одночасно на текстових, зображувальних та відеоданих, що означає, що візуальне розуміння вплетено в основні представлення моделі, а не приклеєно ззовні.

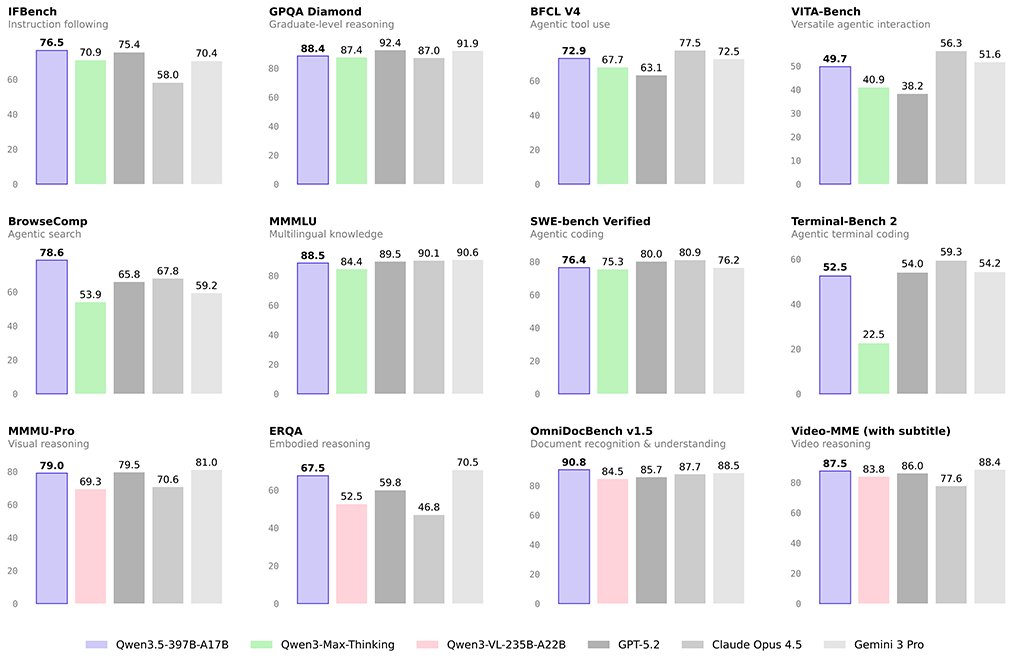

Це має практичне значення. Нативні мультимодальні моделі, як правило, перевершують свої аналоги з адаптерами у завданнях, що вимагають тісної взаємодії тексту та зображень – наприклад, аналіз технічної діаграми разом з документацією, обробка скріншотів інтерфейсу для завдань агентів або вилучення структурованих даних зі складних візуальних макетів. На тесті MathVista модель демонструє результат 90.3, а на MMMU – 85.0. Вона поступається Gemini 3 на деяких бенчмарках, специфічних для обробки зображень, але перевершує Claude Opus 4.5 у мультимодальних завданнях і показує конкурентоспроможні результати порівняно з GPT-5.2, при цьому використовуючи значно меншу кількість параметрів.

Показники продуктивності Qwen 3.5 на бенчмарках порівняно з більшими пропрієтарними моделями – це саме ті цифри, які стимулюватимуть корпоративні дискусії.

Згідно з опублікованими Alibaba результатами тестувань, модель 397B-A17B перевершує Qwen3-Max – модель з понад трильйоном параметрів – у численних завданнях, пов’язаних з міркуваннями та написанням коду.

Крім того, заявлено конкурентоспроможні результати порівняно з GPT-5.2, Claude Opus 4.5 та Gemini 3 Pro у загальних тестах на міркування та програмування.

Мовне покриття та ефективність токенізатора

Однією з недооцінених деталей у релізі Qwen 3.5 є розширене багатомовне охоплення. Словниковий запас моделі збільшено до 250 тис. токенів (у попередніх версіях Qwen було 150 тис.), що наближається до показників токенізатора Google (близько 256 тис.). Підтримка мов розширена зі 119 мов у Qwen 3 до 201 мови та діалекту.

Оновлення токенізатора має прямий вплив на вартість глобальних розгортань. Більші словники ефективніше кодують нелатинські сценарії письма – арабську, тайську, корейську, японську, хінді та інші, скорочуючи кількість токенів на 15-40% залежно від мови. Для ІТ-організацій, що масштабують використання ШІ для багатомовної аудиторії, це не теоретичний момент. Це безпосередньо призводить до зниження витрат на інференс та прискорення часу відповіді.

Агентські можливості та інтеграція з OpenClaw

Alibaba позиціонує Qwen 3.5 як модель для створення агентів (agentic model) – тобто, таку, що призначена не лише для відповідей на запити, а й для автономного виконання багатокрокових дій від імені користувачів та систем. Компанія випустила відкритий код Qwen Code – інтерфейс командного рядка, що дозволяє розробникам делегувати моделі складні завдання з програмування, використовуючи природну мову. Це аналогічно Claude Code від Anthropic.

Реліз також підкреслює сумісність з OpenClaw – відкритим фреймворком для створення агентів, який здобув значну популярність серед розробників цього року. Завдяки 15 000 унікальних середовищ для навчання з підкріпленням, що використовуються для вдосконалення міркувань моделі та виконання завдань, команда Qwen зробила свідому ставку на навчання з підкріпленням для покращення практичної продуктивності агентів. Ця тенденція узгоджується з тим, що демонструвала MiniMax зі своєю моделлю M2.5.

Хостингова версія Qwen3.5-Plus також пропонує адаптивні режими виведення: швидкий режим для завдань, чутливих до затримок, режим “мислення” для розширених ланцюжків міркувань у складних завданнях та автоматичний (адаптивний) режим, який динамічно обирає оптимальний. Така гнучкість є важливою для корпоративних розгортань, де одна й та сама модель може обслуговувати як взаємодії з клієнтами в реальному часі, так і глибокі аналітичні робочі процеси.

Реалії розгортання: що насправді потрібно знати IT-командам

Запуск відкритих версій Qwen 3.5 локально потребує серйозного обладнання. Квантована версія потребує приблизно 256 ГБ оперативної пам’яті, а для комфортної роботи – реально 512 ГБ. Це не модель для робочої станції чи скромного сервера. Вона підходить для GPU-вузла – конфігурації, яку багато підприємств вже використовують для завдань інференсу, і яка тепер пропонує привабливу альтернативу розгортанням, що залежать від API.

Усі відкриті моделі Qwen 3.5 випускаються під ліцензією Apache 2.0. Це суттєва відмінність від моделей з кастомними або обмеженими ліцензіями: Apache 2.0 дозволяє комерційне використання, модифікацію та розповсюдження без роялті, без суттєвих умов. Для юридичних відділів та відділів закупівель, що оцінюють відкриті моделі, така чиста ліцензійна політика значно спрощує процес.

Що буде далі

Alibaba підтвердила, що це перший випуск у сімействі Qwen 3.5, а не повний реліз. Спираючись на досвід Qwen 3, яка включала моделі до 600 мільйонів параметрів, індустрія очікує появи менших дистильованих щільних моделей та додаткових конфігурацій MoE протягом найближчих тижнів та місяців. Модель Qwen3-Next 80B, випущена минулого вересня, вважалася недотренованою, що свідчить про ймовірний швидкий випуск варіанту 3.5 відповідного масштабу.

Для IT-керівників траєкторія зрозуміла. Alibaba продемонструвала, що відкриті моделі на передовій більше не є компромісом. Qwen 3.5 – це реальний варіант для закупівель команд, які прагнуть отримати передові можливості міркування, нативну мультимодальність та контекстне вікно 1 мільйон токенів – без прив’язки до пропрієтарного API. Наступне питання полягає не в тому, чи достатньо потужна ця родина моделей. Воно полягає в тому, чи готова ваша інфраструктура та команда скористатися її перевагами.

Qwen 3.5 доступна зараз на Hugging Face під ідентифікатором моделі Qwen/Qwen3.5-397B-A17B. Хостинговий варіант Qwen3.5-Plus доступний через Alibaba Cloud Model Studio. Qwen Chat на chat.qwen.ai пропонує безкоштовний публічний доступ для оцінки.

Порада від ІТ-Блог: Нова модель Qwen 3.5 від Alibaba – це значний прорив, що пропонує потужні можливості ШІ за більш доступною ціною та з більшою гнучкістю розгортання. Для українських компаній, які прагнуть інтегрувати передові технології штучного інтелекту, це чудова новина, що дозволяє розглядати локальні або хмарні рішення замість залежності від дорогих API. Особливо цінними є покращена багатомовність та нативна мультимодальність, що відкриває нові горизонти для застосування ШІ в локалізованих продуктах та послугах.

Джерело новини: venturebeat.com