Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

OpenAI представила GPT-4 — новейшую версию своей большой языковой ИИ-модели, которая, демонстрирует «производительность на уровне человека» во многих профессиональных задачах. GPT-4 намного больше предыдущих версий — она была обучена на большем количестве данных и использует больший объём информации, что делает нейросеть более дорогой в работе. При этом GPT-4 способна работать не только с текстом, но и с изображениями, хотя на выходе она по-прежнему даёт только текст.

Большая языковая модель GPT от OpenAI используется во многих системах искусственного интеллекта, которые поразили людей в технологической отрасли за последние шесть месяцев, включая ChatGPT и поисковик Bing с ИИ. Новейшая GPT-4 — это предварительный просмотр новых достижений, которые могут начать просачиваться в потребительские продукты, такие как чат-боты, в ближайшие недели. ИИ-бот в Bing уже использует GPT-4, сообщила Microsoft во вторник.

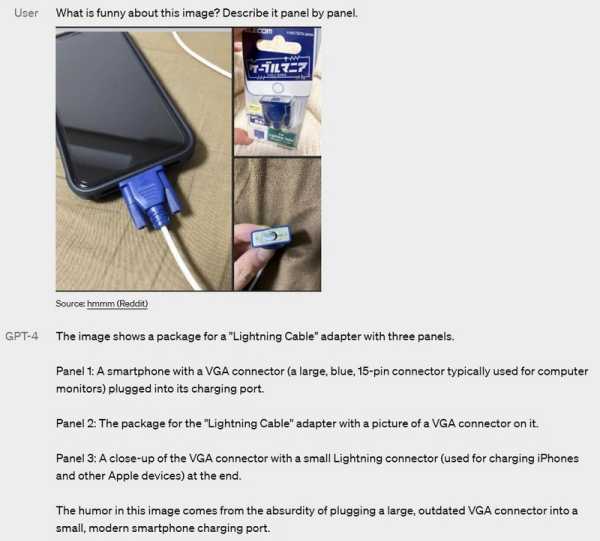

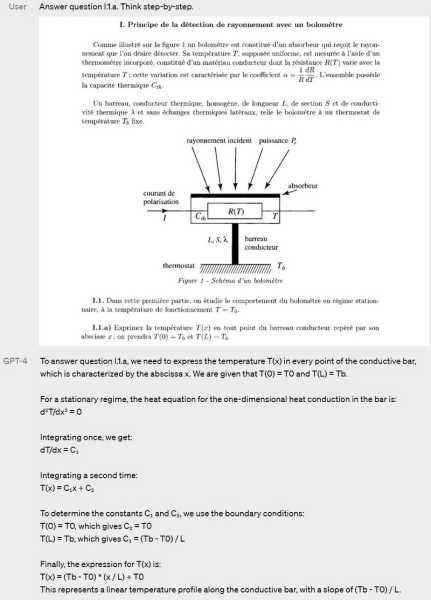

Важнейшим нововведением GPT-4 стала поддержка не только текста, но и изображений в качестве вводных. Новая версия нейросети может понимать, что изображено на фото, схеме, рисунке или другом изображении, и учитывать эти данные при решении задачи. Ещё ИИ способно объяснять данные, представленные в виде диаграммы. Но пока что поддержка с изображений проходит закрытое тестирование.

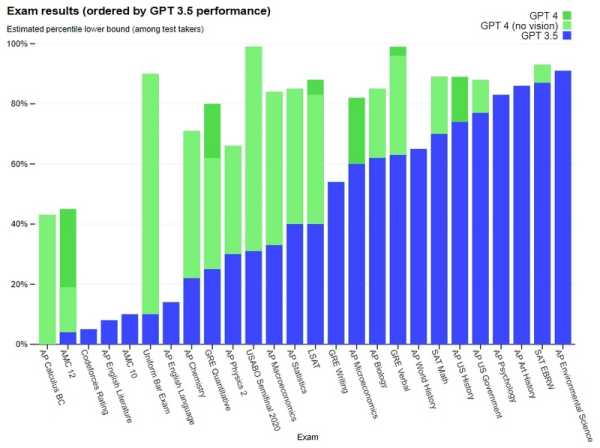

OpenAI утверждает, что новая модель будет давать меньше фактически неверных ответов, реже «сходить с ума» и говорить на запрещенные темы, и даже показывать лучшие результаты, чем люди, во многих стандартизированных тестах. Касательно последнего, по заявлению OpenAI, модель GPT-4 сдала смоделированный адвокатский экзамен лучше 90 % людей, экзамен SAT Reading test (нужно ответить на вопросы по небольшим текстам) — лучше, чем 93 % людей, а экзамен SAT по математике — лучше, чем 89 % людей.

Однако OpenAI предупреждает, что новое программное обеспечение еще не совершенно и что во многих сценариях оно уступает человеку. По словам компании, у модели всё ещё есть серьезные проблемы с «галлюцинациями» (выдумыванием фактов), так что она не является надёжной с точки зрения представления фактов. GPT-4 по-прежнему склонна настаивать на своей правоте, когда ошибается.

«GPT-4 по-прежнему имеет множество известных ограничений, над устранением которых мы работаем, таких как социальные предубеждения, галлюцинации и состязательные подсказки, — говорится в сообщении компании — В обычном разговоре разница между GPT-3.5 и GPT-4 может быть малозаметной. Разница проявляется, когда сложность задачи достигает достаточного порога — GPT-4 более надежен, креативен и способен обрабатывать гораздо более тонкие инструкции, чем GPT-3.5».

В настоящее время многие исследователи в области ИИ считают, что большинство последних достижений в сфере ИИ связаны с запуском все более крупных моделей, обученных на тысячах компьютерных систем. Такое обучение может стоить десятки миллионов долларов. GPT-4 является примером подхода, основанного на увеличении масштаба для достижения лучших результатов.

Microsoft инвестировала миллиарды в OpenAI и для обучения модели GPT-4 использовалась облачная инфраструктура Microsoft Azure. Разработчики не опубликовали подробностей о конкретном размере модели или аппаратном обеспечении, которое они использовали для её обучения и которое может быть применено для воссоздания модели, сославшись на «конкурентную среду».

Новая модель сначала будет доступна платным подписчикам ChatGPT, а также будет доступна в составе API, что позволит сторонним разработчикам интегрировать ИИ в свои приложения. Для доступа к API нужно записаться на лист ожидания. OpenAI будет взимать около 3 центов за примерно 750 слов подсказок и 6 центов за примерно 750 слов ответа.

Источник: